はじめに

動画の解像度を上げる「ビデオスーパーレゾリューション(VSR)」は、スマホの写真やライブ配信で低品質な動画をきれいに直す技術です。最近、AIの拡散モデル(Diffusion Model)がこれを進化させましたが、処理が遅く、高解像度動画に弱い問題がありました。そこで登場したのがFlashVSRです。このモデルは、リアルタイムで動画をストリーミング処理し、解像度を上げてクリアに改善します。AI初心者でもわかるように、基本から説明します。FlashVSRは、効率的な学習方法と賢い工夫で、従来の12倍以上の速さを実現。動画の質を上げたい人にぴったりです。

FlashVSRとは?概要とメリット

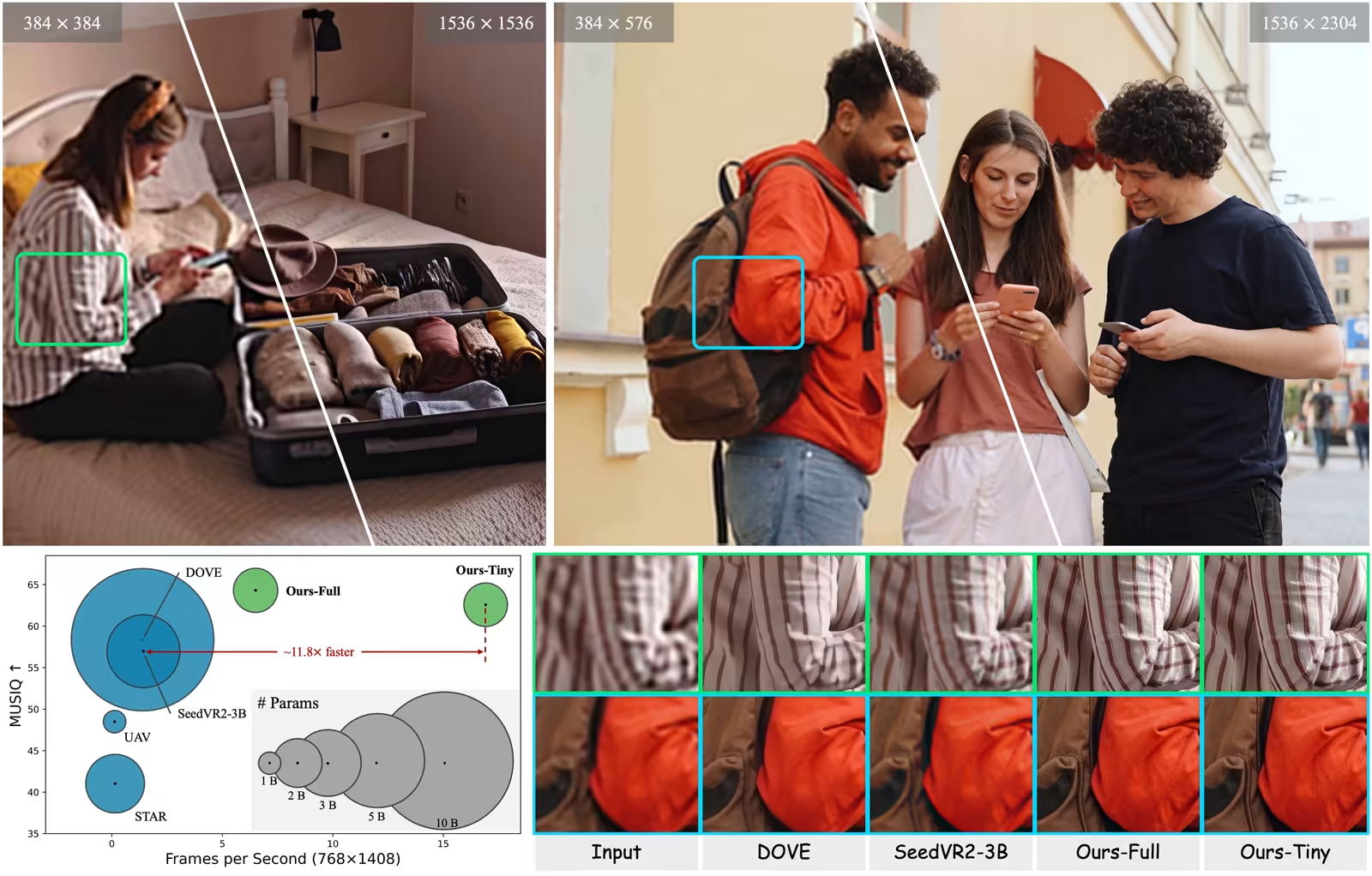

FlashVSRは、中国の研究チームが開発したAIモデルで、拡散モデルを基に動画の超解像度化をリアルタイムで行います。拡散モデルとは、ノイズ(雑音)を加えた画像から徐々にきれいな画像を作り出すAIの手法です。FlashVSRのポイントは以下の通り:

- リアルタイム処理: 768×1408の動画を1秒に17フレーム(FPS)で処理。A100 GPU1枚でOK。

- ストリーミング対応: 動画をチャンク(塊)ごとに分けて処理せず、連続的に扱えるので、遅延が少ない(わずか8フレーム)。

- 高解像度対応: 1440p(超高解像度)までスケール可能。訓練時と実際の解像度のギャップを解消。

- 新しいデータセット: VSR-120Kという、12万本の動画と18万枚の画像を使った大規模データで訓練。質の高いデータでAIを強くする。

これにより、スマホ撮影やソーシャルメディアの動画が、ぼやけた低解像度からシャープで詳細な高解像度に変わります。AI newbieにとって、FlashVSRは「動画を魔法のようにクリアにするツール」みたいなものです。

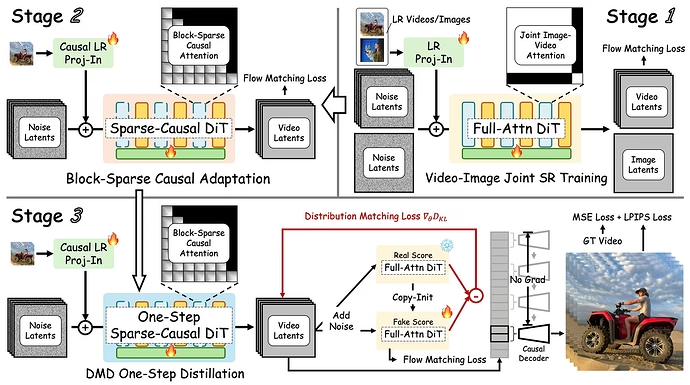

FlashVSRの仕組み:3段階の学習プロセス

FlashVSRはどうやって動くのか? 複雑な拡散モデルを効率的にするために、3つのステージで学習します。初心者向けに、簡単にステップバイステップで説明します。

-

ステージ1: 画像と動画の共同訓練

事前学習済みの拡散モデル(Wan 2.1)を基に、画像と動画を一緒に訓練。画像を「1フレームの動画」として扱い、フルアテンション(全ての部分に注目)で学習。低解像度(LR)入力から高解像度(HR)を出力する基本を築く。- ここで使うのは「フロー・マッチング損失」という、ノイズを減らす学習方法。

-

ステージ2: スパース因果アテンションの適応

フルアテンションを効率化。スパース(まばら)アテンションで、無駄な計算を減らす。具体的には、キー・バリューをブロックに分け、トップkの重要な部分だけ計算。- 因果マスクで、過去のフレームだけ参照(未来は見ない)。これでストリーミングが可能に。

- 計算コストを10-20%に削減。

-

ステージ3: 1ステップ蒸留

多ステップの拡散を1ステップに圧縮。分布マッチング蒸留(DMD)で、教師モデルから生徒モデルへ知識を移す。- LRフレームとノイズを入力に、並列処理で効率化。

- 損失関数: 分布マッチング + フロー・マッチング + ピクセル再構成(MSE + LPIPS)。

これで、動画生成とは違い、VSR特有の「LR入力依存」でエラーを防ぐ。

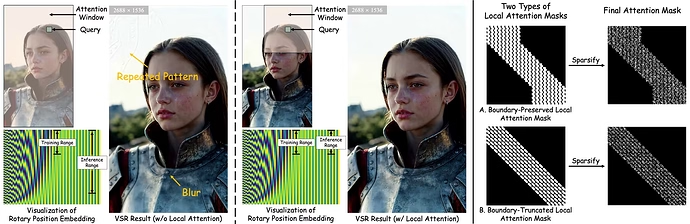

さらに、局所制約付きスパースアテンションで、高解像度時の位置エンコーディングのずれを防ぎます。クエリ(注目点)をローカルウィンドウに制限し、訓練時と推論時の範囲を一致させる。これで、繰り返しパターンやぼやけを避けます。

動画のアップスケールと改善方法

FlashVSRは、低解像度動画をどうアップスケール(解像度アップ)して改善するのか? 基本は、拡散モデルでノイズを除去し、詳細を追加します。

-

アップスケールの流れ:

- LR動画を入力。

- ノイズを加えて潜在空間(latent space)に変換。

- スパースアテンションで時間・空間の関連を計算(過去フレームを参考に一貫性確保)。

- 1ステップでノイズ除去し、HR潜在を生成。

- Tiny Conditional DecoderでLRを補助入力に使い、HR動画を出力。

-

改善のポイント:

- 詳細追加: ぼやけたテクスチャをシャープに。例: 顔の輪郭や背景の細部がクリアに。

- 時間的一貫性: 動画の動きを滑らかに保つ(ちらつきなし)。

- 効率化: 従来の3Dアテンションの計算を減らし、リアルタイムに。デコーダーを小さくして、処理時間を1/7に短縮。

AI newbieの例: 古いスマホ動画を4K級にアップ。圧縮で失われた質をAIが「想像」して復元します。

この方法で、FlashVSRはDOVEやSeedVR2より優れた視覚品質を実現。実験では、PSNRやSSIMなどの指標でトップ。

他のモデルとの比較

FlashVSRを既存モデルと比べてみましょう。以下は、主なVSRモデルの比較表です。データは論文に基づく。

| モデル | メリット | デメリット |

|---|---|---|

| FlashVSR | リアルタイム(17 FPS)、ストリーミング、低遅延、高解像度対応、12倍速い | 専用GPUが必要 |

| DOVE | 1ステップで高品質、知覚指標が高い | 遅い(0.5 FPS)、メモリ消費大 |

| SeedVR2-3B | 強力な拡散ベース、詳細復元良好 | 1.4 FPS、メモリ52.9 GB、チャンク処理で遅延大 |

| STAR | 多ステップで細かい調整可能 | 非常に遅い(0.15 FPS)、15ステップ必要 |

| Upscale-A-Video | 光学フローで動き対応 | 30ステップで遅く(0.12 FPS)、高解像度に弱い |

| RealViFormer | 非拡散で速い | 品質が低く、訓練データ依存 |

FlashVSRは効率と品質のバランスが抜群。一方で、多ステップモデルは品質が高いが実用性に欠けます。実験では、VideoLQデータセットでFlashVSRが視覚的に自然な結果を出しています。

結論とおすすめ

FlashVSRは、AIの拡散モデルを活用して動画をリアルタイムで高解像度化する画期的な技術です。初心者でも、3段階学習とスパースアテンションの工夫で高速化を実現しているのがわかります。これを使えば、低品質動画がプロ級に改善され、ライブ配信やスマホ編集が楽になります。おすすめは、コードとモデルが公開されているので、興味がある人はGitHubで試してみてください。AIの未来を感じるツールですよ! 皆さんの動画体験が変わるかも? コメントで感想をシェアしましょう。